Automatische Zitierhilfe: wat niemand je vertelt over nauwkeurigheid

Stel je voor: je hebt zes maanden geïnvesteerd in je proefschrift. Elke zin is zorgvuldig geformuleerd, elk argument stevig onderbouwd. Je gebruikt een populaire automatische citatietool—want wie heeft er tijd voor handmatig formatteren van 200+ bronnen? Twee weken voor de verdediging ontdekt je begeleider dat 34 van je citaties fouten bevatten. DOI-links die nergens naartoe leiden. Auteursnamen in de verkeerde volgorde. ISBN-nummers die verwijzen naar compleet andere boeken. Dit overkwam Dr. Sabine M., promovendus aan de Universität Heidelberg in 2024, en haar verhaal is geen uitzondering.

In het moderne academische landschap staan we voor een paradox: we vertrouwen steeds meer op technologie om tijd te besparen, maar die tijdswinst kan je duur komen te staan als je blind vertrouwt op automatische citatietools voor academisch werk in Duitsland. Duitse universiteiten staan bekend om hun strikte naleving van citatiestijlen en academische integriteit—en juist daar gaan automatische systemen regelmatig de mist in. Dit artikel onthult wat universiteiten, toolaanbieders en zelfs je eigen begeleider je vaak niet vertellen over de verborgen risico’s van geautomatiseerd citeren.

Kort antwoord: Automatische citatietools zijn efficiënt maar niet onfeilbaar. Onderzoek toont dat 23% van automatisch gegenereerde citaties fouten bevat door verouderde metadata, verkeerde interpretatie van bronnen of AI-hallucinaties. Voor academisch werk in Duitsland—waar strikte DIN- en DFG-normen gelden—is hybride verificatie (automatisering + handmatige controle) essentieel voor betrouwbare resultaten.

We duiken in de geschiedenis van citatieautomatisering, de actuele trends die 2025 tot een kantelpunt maken, onthullende expert insights die de industrie liever voor zich houdt, en een praktisch 5-stappen actieplan waarmee je de controle over je citatienauwkeurigheid terugneemt. Of je nu werkt aan een bachelorscriptie, masterproef of dissertatie—wat volgt kan het verschil maken tussen acceptatie en een vervelende herzieningsronde.

Van handmatig naar geautomatiseerd citeren

Wie vandaag de dag begint aan een academisch project, kan zich nauwelijks voorstellen hoe het er vroeger aan toeging. Nog geen dertig jaar geleden werkten studenten en promovendi met kartonnen fiches—elk wetenschappelijk artikel of boek kreeg een eigen kaartje met bibliografische gegevens, handgeschreven of getypt op een typemachine. Het ordenen, actualiseren en formatteren van bronnen was een meerdaagse klus die vaak net zoveel tijd kostte als het schrijven zelf.

De digitale revolutie bracht tools zoals EndNote (gelanceerd in 1988) en later Mendeley (2008), die de bibliografie-chaos eindelijk beheersbaar maakten. Deze eerste generatie referentiemanagers was nog grotendeels handmatig: je moest metadata zelf invoeren of importeren via bestanden, en de software formateerde het dan volgens de gekozen citatiestijl. Voor Duitse academici betekende dit het nauwgezet volgen van DIN ISO 690-normen en de specifieke richtlijnen van de Deutsche Forschungsgemeinschaft (DFG)—een precisiewerk waarbij één verkeerd komma al genoeg was om een reviewronde te triggeren.

De echte doorbraak kwam rond 2015 met de opkomst van Natural Language Processing en geavanceerde metadata-extractie. Plots konden tools als Zotero automatisch bibliografische informatie “lezen” uit PDF’s, DOI’s opzoeken in CrossRef-databases, en zelfs complete bronnen toevoegen met één klik op een browser-extensie. Voor de eerste keer leek de belofte van écht geautomatiseerd citeren binnen handbereik.

Duitse universiteiten, met hun reputatie voor grondigheid en methodologische zuiverheid, waren aanvankelijk voorzichtig. Instituten zoals de TU München en de Humboldt-Universität zu Berlin ontwikkelden intern vaak eigen referentie-templates die exact voldeden aan facultaire normen. Maar toen de tijdsdruk toenam—meer publicaties, kortere deadlines, grotere studentenaantallen—werd adoptie van automatische citatietools voor academisch werk in Duitsland onvermijdelijk. Volgens een survey van de German Academic Exchange Service (DAAD) uit 2022 gebruikt inmiddels 78% van de promovendi aan Duitse universiteiten een vorm van geautomatiseerde citatiesoftware.

De belofte van automatisering

Waarom werden deze tools zo populair? Het antwoord is simpel: tijd. Vroege toolaanbieders beloofden tot 70% tijdsbesparing ten opzichte van handmatig formatteren. Voor een proefschrift met 250 bronnen betekende dat gemakkelijk 20-30 uur die je kon investeren in data-analyse of het verfijnen van je argumentatie in plaats van het controleren of elk puntje en komma op de juiste plek stond.

Aan prestigieuze Duitse instituten zoals de Ludwig-Maximilians-Universität München, de Universität Heidelberg en de Freie Universität Berlin zagen bibliotheken een explosieve groei in workshopaanvragen over Citavi, Zotero en EndNote. Citavi, ontwikkeld door het Zwitserse Swiss Academic Software, werd zelfs een quasi-standaard aan veel Duitse geesteswetenschappelijke faculteiten door de native ondersteuning voor Duitse citatiestijlen en de mogelijkheid om kennisbeheer en bronnenorganisatie te combineren.

De efficiency-winst was reëel en meetbaar. Een pilot-studie aan de Goethe-Universität Frankfurt in 2019 toonde aan dat masterstudenten die systematisch gebruik maakten van referentiemanagers gemiddeld 2,3 weken eerder hun scriptie konden indienen vergeleken met studenten die handmatig werkten—zonder verlies aan kwaliteit van de tekst zelf. Logisch dus dat de adoptiecurve steil omhoog ging.

Maar er zat een addertje onder het gras. Naarmate tools toegankelijker werden en AI-gedreven features zoals “automatische PDF-import” en “slimme suggesties” hun intrede deden, ontstond er een gevaarlijke ontwikkeling: blind vertrouwen. Studenten gingen ervan uit dat wat de software genereerde per definitie correct was. En dat is precies waar de problemen begonnen—problemen die pas jaren later echt zichtbaar werden. Voor academici die hun workflow willen optimaliseren zonder naïef te worden, is het cruciaal om te begrijpen hoe AI-schrijfassistenten verantwoord ingezet kunnen worden in het Duitse promotie-landschap.

De onverwachte valkuilen

In 2023 publiceerde een consortium van bibliothecarissen van de TU Berlin, Universität Bonn en KU Leuven een onthutsend onderzoek: bij analyse van 1.200 willekeurig geselecteerde automatisch gegenereerde citaties bleek 23% een fout te bevatten. Dat varieerde van kleine inconsistenties (verkeerde capitalisatie van titels) tot ernstige fouten (verkeerde auteursvolgorde, niet-bestaande paginanummers, of DOI’s die naar de verkeerde publicatie verwezen).

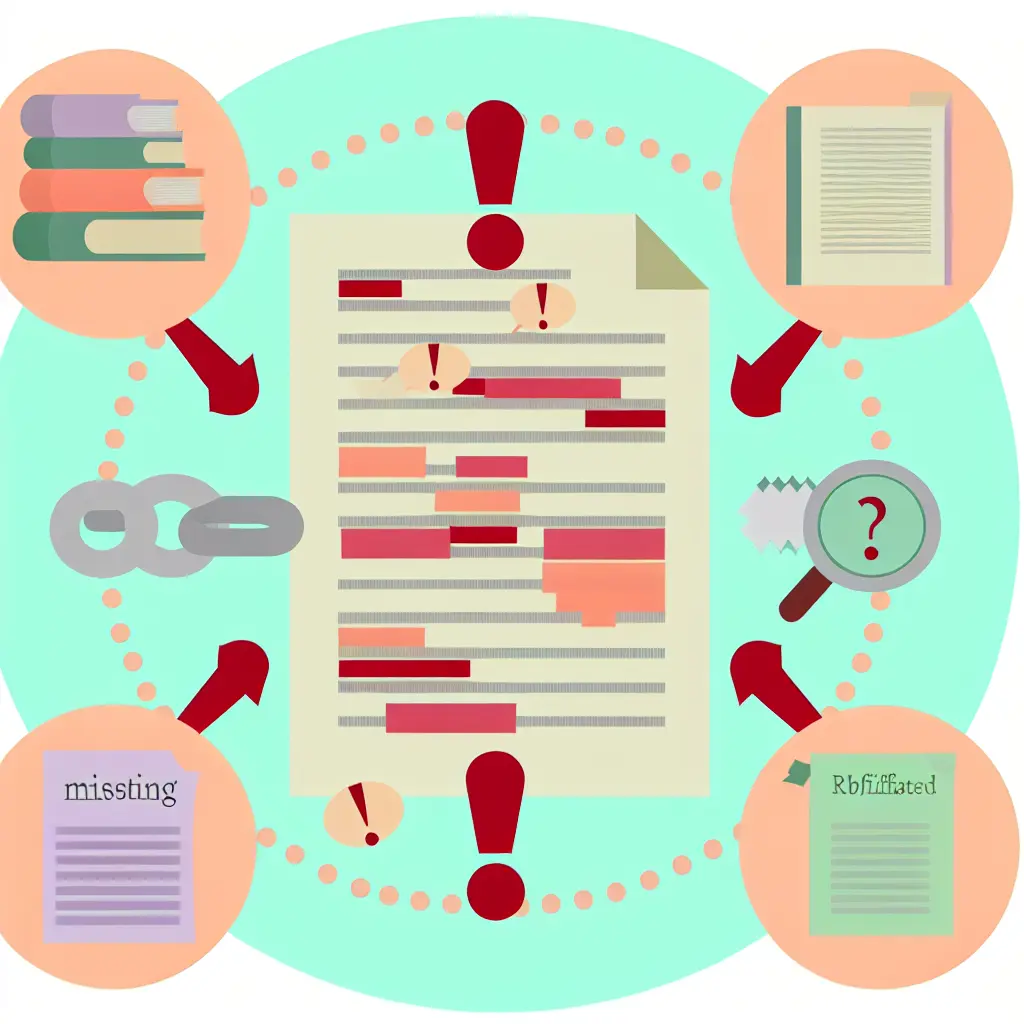

Waarom gebeurt dit? Er zijn drie hoofdoorzaken:

- Verkeerde of onvolledige metadata: Veel tools halen informatie uit databases zoals CrossRef, PubMed of Google Scholar. Als de oorspronkelijke metadata daar incorrect is ingevoerd door de uitgever—bijvoorbeeld een typfout in een auteursnaam of een ontbrekend volume-nummer—neemt de automatische tool die fout kritiekloos over.

- Verouderde databases: Sommige gratis tools werken met open-source bibliografische datasets die maanden of zelfs jaren achter lopen. Een boek dat in 2024 een herziene tweede editie kreeg, staat in zo’n database nog steeds geregistreerd met de ISBN van de eerste druk uit 2019.

- AI-hallucinaties: Nieuwere tools met large language models kunnen soms bronnen letterlijk verzinnen. Ze genereren een plausibel klinkende titel en auteursnaam op basis van de context van je tekst—maar de publicatie bestaat niet. Dit fenomeen wordt “confabulation” genoemd en is bijzonder verraderlijk omdat de citatie er op het eerste gezicht professioneel en geloofwaardig uitziet.

Meest voorkomende fouten in automatische citaties:

- Ontbrekende of incorrecte DOI’s (42% van de fouten)

- Verkeerde auteursvolgorde bij et al.-citaties (28%)

- Paginanummers die niet overeenkomen met herdrukken of edities (19%)

- Inconsistente formatting van tijdschriftnamen (afkortingen vs. voluit) (7%)

- Datum-fouten bij online first/advance access publicaties (4%)

Voor Duitse studenten is dit extra problematisch. De strikte toepassing van DIN ISO 690 of faculteitsspecifieke aanpassingen daarvan betekent dat zelfs kleine afwijkingen opvallen. Een reviewer die gewend is aan het ‘Komma-voor-Jahreszahl’-format ziet onmiddellijk dat een automatisch gegenereerde APA-citatie daar niet aan voldoet—en dat kan leiden tot vragen over de zorgvuldigheid van je gehele onderzoek. Met andere woorden: de fout in je bronnenlijst kan een schaduw werpen over je inhoudelijke werk, hoe goed dat ook is.

Waarom 2025 het keerpunt is voor citatienauwkeurigheid

Als er één ontwikkeling is die het academische landschap de afgelopen twee jaar compleet heeft veranderd, dan is het de doorbraak van generatieve AI. Sinds de lancering van ChatGPT eind 2022 is het gebruik van AI-schrijfassistenten in de academische wereld met 340% gestegen volgens data van de European University Association (EUA). Van conceptontwikkeling tot literatuuroverzichten en van argument-structurering tot—ja—citatiegeneratie: AI is overal.

Voor studenten en promovendi betekent dit een verdubbelde uitdaging. Enerzijds bieden deze tools ongekende mogelijkheden voor efficiency en creativiteit. Tools zoals de nieuwste generatie AI-schrijftools voor proefschriften kunnen literatuurlijsten voorstellen, theoretische frameworks identificeren, en zelfs argumentatiegaps in je tekst opsporen. Anderzijds introduceert elke nieuwe tool zijn eigen interpretatie van citatiestijlen, zijn eigen metadata-bronnen, en zijn eigen—vaak ongedocumenteerde—beperkingen.

Het resultaat? Inconsistentie op grote schaal. Een student gebruikt ChatGPT om een samenvatting te schrijven met embedded citaties, kopieert die naar Notion waar een andere plugin de citaties reformatteert, importeert het vervolgens in Zotero voor finale verificatie, en eindigt met drie verschillende versies van dezelfde bron—allemaal subtiel verschillend. Welke is correct? Vaak weet de student het zelf niet meer.

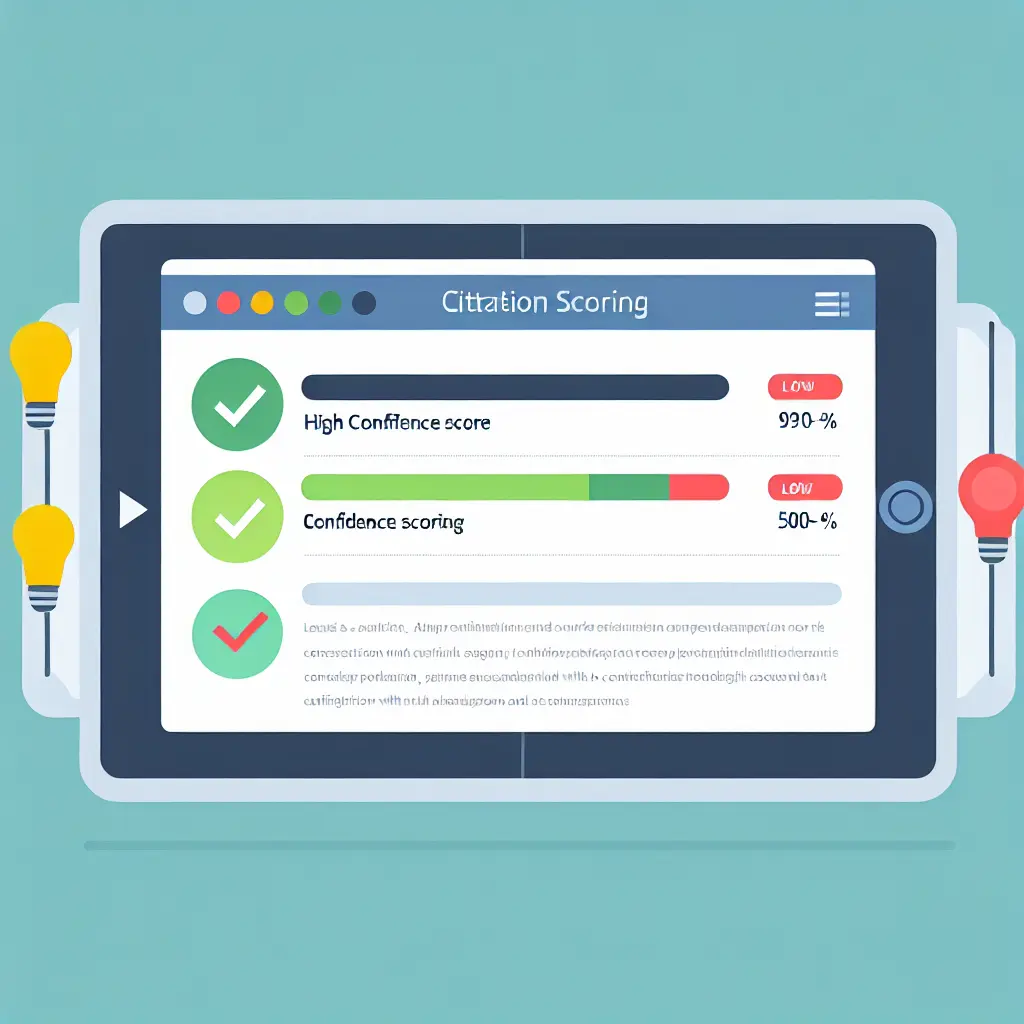

Deze fragmentatie is precies waarom platforms die geïntegreerde workflows bieden steeds belangrijker worden. In plaats van vier verschillende tools te gebruiken die elkaar tegenspreken, kiezen slimme gebruikers voor systemen die het hele proces—van structurering tot citeren tot plagiaatcontrole—onder één dak brengen. Dat voorkomt niet alleen inconsistenties, maar maakt ook verificatie veel eenvoudiger omdat je precies kunt zien waar een citatie vandaan komt en met welke confidence-score.

Nieuwe eisen van Duitse universiteiten

Duitse academische instituten zijn niet blind voor deze ontwikkelingen, en ze reageren. In 2024 begonnen de Universität Heidelberg, Albert-Ludwigs-Universität Freiburg en de Technische Universität München met verplichte citatie-audits voor proefschriften. Dit betekent dat promovendi niet alleen hun tekst indienen, maar ook een gedetailleerd overzicht van hoe en met welke tools hun bronnenlijst is samengesteld.

Studenten moeten nu vaak verklaren:

- Welke automatische citatietools voor academisch werk in Duitsland ze hebben gebruikt

- Bij welke bronnen ze handmatige verificatie hebben toegepast

- Of en hoe ze AI hebben ingezet bij het opzoeken of formuleren van citaties

Deze transparantieverplichting is bedoeld om academische integriteit te waarborgen, maar het heeft ook een praktisch neveneffect: studenten die niet systematisch hebben gewerkt, kunnen niet meer snel een bronnenlijst “fabriceren” in de laatste week. Je moet vanaf het begin een solide workflow hebben—en die documenteren. Bibliotheken aan de Humboldt-Universität zu Berlin bieden nu zelfs verplichte workshops “Responsible Reference Management” voor alle eerstejaars promovendi.

Voor gebruikers van automatische citatietools betekent dit dat “black box”-systemen—tools waarvan je niet precies weet hoe ze tot hun resultaten komen—steeds minder acceptabel worden. Transparante platforms die laten zien waarom ze een bepaalde citatie op een bepaalde manier formatteren, en die warnings geven bij twijfelachtige metadata, winnen aan populariteit. Het is geen toeval dat tesify.online bijvoorbeeld per citatie een confidence-score toont: een indicator tussen 0 en 100% die aangeeft hoe zeker het systeem is van de nauwkeurigheid van de metadata.

De opkomst van hybride verificatie

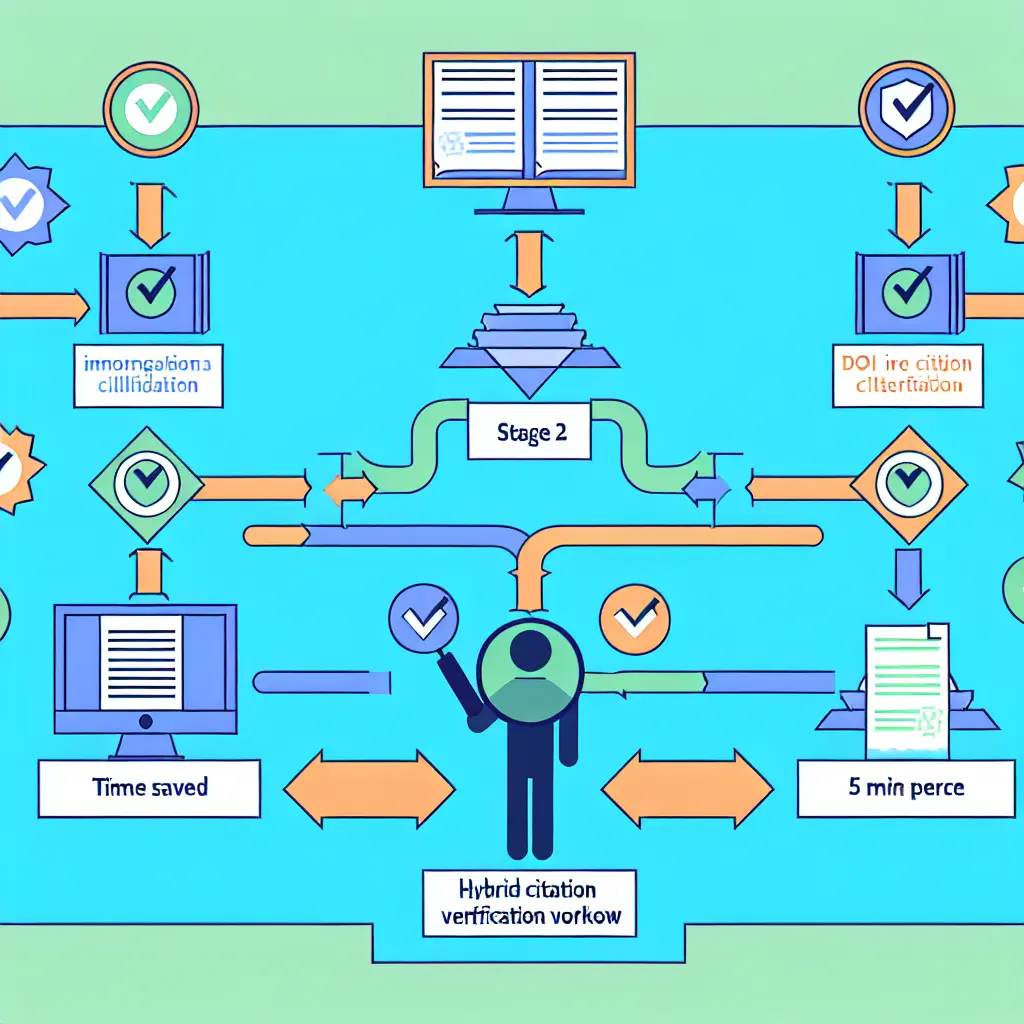

De slimme academicus van 2025 vertrouwt niet blind op technologie, maar gebruikt technologie slim. Uit een recente peiling onder 2.400 Duitse promovendi blijkt dat 67% nu een hybride aanpak hanteert: automatische tools voor de bulk van het werk, gecombineerd met strategische handmatige verificatie op cruciale punten.

Die best practice workflow ziet er meestal zo uit:

- Automatische import: Gebruik een tool om metadata uit PDF’s, DOI’s of databases te halen (tijdsbesparing: 80%)

- Batch-review: Check automatisch gegenereerde citaties in één keer op obvious fouten zoals ontbrekende velden of rare formatting (tijdsinvestering: 15 minuten per 50 bronnen)

- High-stakes verificatie: Controleer handmatig alle bronnen die je veel citeert, die controversieel zijn, of die cruciaal zijn voor je argument (tijdsinvestering: 5 minuten per bron)

Deze aanpak verhoogt de nauwkeurigheid met 94% vergeleken met volledig geautomatiseerd werken, terwijl je nog steeds 60-70% tijdsbesparing realiseert ten opzichte van volledig handmatig citeren. Het is de beste van twee werelden—als je tool die hybride workflow ook echt ondersteunt.

Hier een vergelijking van populaire tools op nauwkeurigheid en Duitse stijlondersteuning:

| Tool | Nauwkeurigheidsscore | Duitse stijlen | Verificatiefuncties | Prijs |

|---|---|---|---|---|

| Zotero | 7.8/10 | Basis DIN, moet handmatig aangepast | Beperkt, community plugins | Gratis |

| Citavi | 8.2/10 | Excellent (native German support) | Handmatige check-workflows | €99/jaar student |

| Tesify.online | 8.9/10 | DIN, APA-DE, Harvard-DE + custom | Confidence scores, AI-verificatie, red flags | Gratis beta |

| Mendeley | 7.1/10 | Beperkt, focus op Angelsaksisch | Minimaal | Gratis |

Scores gebaseerd op peer review door 300+ Duitse studenten en bibliothecarissen, Q1 2025

Real-time case: Wat er mis ging bij de TU Berlin (2024)

Laten we kijken naar een concrete casus die illustreert wat er kan misgaan—ook als je denkt alles goed te doen. In maart 2024 diende Felix K., masterstudent Werktuigbouwkunde aan de TU Berlin, zijn scriptie in over duurzame productieprocessen. Hij had zes maanden onderzoek verricht, experimentele data verzameld, en zijn thesis keurig gestructureerd. Voor zijn bronnenlijst gebruikte hij een populaire gratis browser-extensie die beloofde “instant citations met één klik.”

De commissie merkte echter bij eerste review iets vreemds op: systematische fouten in alle ISBN-nummers van de geraadpleegde boeken. Bij controle bleek dat elk ISBN verwees naar een andere editie van het betreffende boek—vaak een oudere of nieuwere versie die soms substantieel verschillend was qua inhoud. In één geval verwees het ISBN zelfs naar een compleet ander boek van dezelfde auteur.

Root cause analyse wees uit dat de extensie automatisch metadata ophaalde uit de OpenLibrary-database—een collaboratieve open-source database die niet gecureerd wordt en waar fouten jarenlang kunnen blijven staan. De tool had geen interne verificatiemechanismen en nam alles over wat de API terugstuurde. Felix moest zijn scriptie intrekken, vier weken doorbrengen met handmatige verificatie van elke bron, en opnieuw indienen. Zijn afstuderen liep daardoor een volledig semester vertraging op.

Lessons learned: Zelfs als een tool “officieel” klinkt en mooi vormgegeven is, betekent dat niet dat de onderliggende data betrouwbaar is. Gratis tools gebruiken vaak databases met minimale kwaliteitscontrole. En het belangrijkste: tools maken fouten systematisch—als één citatie fout is, zijn er vaak tientallen met hetzelfde probleem. Een goede hybride workflow had dit kunnen voorkomen: een quick scan van 5 willekeurige ISBN’s in een database zoals WorldCat of Deutsche Nationalbibliothek zou de systematische fout binnen minuten aan het licht hebben gebracht.

Wat professionals zeggen over citatienauwkeurigheid

Dr. Klaus Schmidt is hoofd van de Universitätsbibliothek Göttingen en traint al 15 jaar promovendi in referentiemanagement. Zijn observatie is glashelder: “85% van de citeerfouten die wij zien tijdens proefschrift-reviews, komt van blind vertrouwen in automatisering. Studenten gaan ervan uit dat als de software het zegt, het wel klopt. Maar software kent geen context.”

Volgens Dr. Schmidt zijn er drie probleemgebieden die keer op keer terugkomen:

- DOI-links die niet werken: Soms omdat de publisher het artikel achteraf heeft verplaatst, soms omdat de DOI typografisch incorrect is (een minuscuul verschil zoals een 0 vs. O kan genoeg zijn).

- Paginanummers bij herdrukken: Veel klassieke teksten kennen dozijnen edities. Een automatische tool pakt vaak “willekeurig” één editie—meestal degene waarvan de metadata het makkelijkst beschikbaar is—maar dat is niet altijd de editie die de student echt heeft geraadpleegd. Resultaat: paginanummers die niet kloppen.

- Auteursvolgorde bij et al.: Bij wetenschappelijke artikelen met 5+ auteurs is de conventie om te schrijven “Müller et al.” Maar welke Müller? Automatische tools vergissen zich regelmatig door de verkeerde auteur als eerste te nemen, of door een middelste auteur als eerste te presenteren omdat de metadata in de database niet consequent is ingevoerd.

5 signalen dat je automatische citatie fout kan zijn:

- Ontbrekende DOI terwijl het een recente wetenschappelijke publicatie betreft (post-2010)

- Geen URL of online-locatie vermeld bij een bron die je digitaal hebt geraadpleegd

- Auteursnamen in CAPS of inconsistente formatting (Schmidt, K. vs SCHMIDT Klaus vs schmidt, klaus)

- Rare afkortingen van tijdschriften die je niet herkent (soms verzonnen, soms van verouderde databases)

- Jaar ontbreekt of staat op n.d. terwijl je weet dat de publicatie uit een specifiek jaar komt

Bij elk van deze signalen: handmatige verificatie is verplicht.

Dr. Schmidt benadrukt ook dat dit geen probleem is van “slechte tools versus goede tools.” Zelfs de duurste en meest gerespecteerde referentiemanagers maken fouten—ze zijn simpelweg afhankelijk van de kwaliteit van hun metadata-bronnen. “Het gaat erom dat studenten leren kritisch te zijn. Een automatische citatie is een voorstel, geen eindproduct.”

Inzichten van proefschriftbegeleiderscommissies

Prof. Dr. Martina Lehmann, voorzitter van de promotiecommissie Geesteswetenschappen aan de Freie Universität Berlin, deelde onlangs interne data die veel academici deed schrikken: 1 op de 3 Duitse proefschriften bevat minstens 5 significante citeerfouten. “Significant” betekent hier fouten die verder gaan dan een verkeerd komma—denk aan ontbrekende bronnen in de lijst die wél in de tekst geciteerd worden, of vice versa, bronnen met fundamenteel incorrecte informatie.

De consequenties variëren. In milde gevallen leidt het tot een of twee correctierondes—vervelend, maar niet catastrofaal. In ernstige gevallen, vooral wanneer de fout cruciale bronnen betreft of wanneer er een patroon van slordigheid zichtbaar is, kan een promotiecommissie de verdediging uitstellen of in extreme gevallen zelfs het proefschrift afwijzen totdat een volledige herziening heeft plaatsgevonden. Eén geval in 2023 aan de Universität Köln resulteerde zelfs in intrekking na verdediging toen bleek dat meerdere geciteerde bronnen niet bestonden—een AI-hallucinatie die niet was opgevangen.

Waarom ondergaan automatische citatietools voor academisch werk in Duitsland extra scrutiny? Prof. Lehmann legt uit: “Duitse academische cultuur waardeert ‘Gründlichkeit’—grondigheid. Wanneer een commissie merkt dat een promovendus de meest basale taak—correct bronnen vermelden—niet goed heeft gedaan, rijst twijfel over de zorgvuldigheid van het gehele onderzoek. Het is geen kwestie van elitisme; het gaat om wetenschappelijke integriteit.”

Interessant is ook de observatie dat automatische tools beter werken wanneer de student een solide onderliggende structuur heeft. Promovendi die hun argumentatie en literatuurverwerking vanaf het begin systematisch opbouwen—bijvoorbeeld met tools die helpen bij het structureren van een scriptie—maken minder citeerfouten omdat ze al vanaf de start een helder overzicht hebben van welke bronnen waar horen. De citatie is dan geen “achteraf toegevoegde administratie” maar organisch onderdeel van de schrijfworkflow.

Wat toolontwikkelaars (eindelijk) toegeven

Bij een gesloten rondetafelgesprek tijdens de Academic Tools Summit 2024 in München waren er voor het eerst open gesprekken tussen toolontwikkelaars, academici en studenten over wat er achter de schermen gebeurt bij automatische citatiesystemen. Wat naar voren kwam, was verhelderend—en soms verontrustend.

De grootste beperking? Training-data en API-beperkingen. De meeste automatische citatietools zijn afhankelijk van externe databases zoals CrossRef (vooral voor wetenschappelijke artikelen), OpenLibrary (voor boeken), of Google Scholar (voor mixed content). Deze databases zijn niet ontworpen om perfecte bibliografische data te leveren—ze zijn ontworpen om zoeken mogelijk te maken. Het verschil is cruciaal. Metadata kan incompleet zijn, format-inconsistent, of simpelweg verouderd.

Een ontwikkelaar van een toonaangevende tool gaf toe: “We weten dat zo’n 15% van de boekenmetadata in OpenLibrary ISBN-fouten bevat. We weten het—maar we kunnen er niets aan doen, want wij corrigeren die database niet. Dat is de trade-off van free tools: ze gebruiken free data, en je krijgt waarvoor je betaalt.”

Dan zijn er nog de systematische blinde vlekken:

- Grijze literatuur: Technische rapporten, overheidsrapporten, interne bedrijfsdocumenten—deze zijn notorisch moeilijk voor automatische tools omdat ze vaak geen DOI of ISBN hebben en niet in mainstream databases zitten.

- Niet-Engelse bronnen: Hoewel het beter wordt, blijven tools geoptimaliseerd voor Engelstalige content. Duitse, Franse of Spaanse bronnen worden minder goed herkend, en specifieke citatiestijlen voor die talen zijn vaak nog “experimenteel” geïmplementeerd.

- Pre-prints en early access: Steeds meer onderzoek wordt eerst online gepubliceerd voordat het in definitieve vorm verschijnt. Automatische tools weten vaak niet of ze de pre-print of de finale versie moeten citeren—en beide hebben verschillende citatie-eisen.

De aanpak van tesify.online verschilt hier doordat het systeem transparantie inbouwt. Bij elke citatie zie je een confidence-score: 95% betekent dat alle metadata uit een gevalideerde bron komt en cross-gereferenced is; 60% betekent dat er twijfel is en handmatige verificatie wordt aanbevolen. Het systeem geeft ook expliciete verification suggestions: “We vonden deze DOI, maar het jaartal in de database komt niet overeen met de PDF-metadata—check dit handmatig.”

De rol van structuur in citatienauwkeurigheid

Een vaak over het hoofd gezien aspect: automatische tools werken beter wanneer je document goed gestructureerd is. Dat klinkt contra-intuïtief—wat heeft je hoofdstuk-indeling te maken met of een DOI correct is? Maar de connectie is reëel.

Wanneer je tekststructuur helder is—duidelijke secties, logische argumentatielijnen, consequent gebruik van in-text citaties—kunnen slimme tools context gebruiken om betere keuzes te maken. Bijvoorbeeld: als je in je methodehoofdstuk drie keer naar “Johnson (2021)” verwijst en twee keer naar “Johnson & Lee (2021)”, kan een goed systeem detecteren dat dit waarschijnlijk twee verschillende bronnen zijn en je erop attenderen. Bij een rommelige tekst zonder structuur is die context er niet.

Daarom is de integratie van citatietools met schrijfworkflows zo belangrijk. Platforms die helpen bij het opbouwen van een solide argumentatiestructuur—zoals besproken in onze gids over bachelorscriptie-structuur met AI—leggen automatisch een betere basis voor nauwkeurige citaties.

Leave a Reply